Kodowanie informacji tekstowych w komputerze

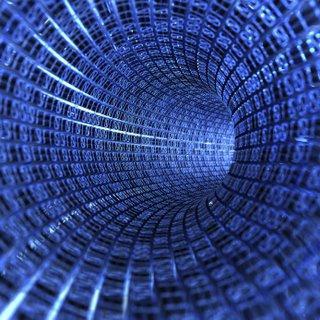

Komputer – wyrafinowanym urządzeniem, dzięki któremu można tworzyć, konwertować i przechowywania informacji. Jednak komputer nie działa bardzo zrozumiały sposób dla nas – grafiki, tekstu i danych numerycznych jest przechowywana jako tablice binarnych  numerów. W tym artykule przyjrzymy się, w jaki sposób kodowania informacji tekstowych.

numerów. W tym artykule przyjrzymy się, w jaki sposób kodowania informacji tekstowych.

Co dla nas jest tekst z komputera – ciąg znaków. Każdy symbol reprezentuje pewien zbiór zer i jedynek. Pod symbole oznacza nie tylko duże i małe litery łacińskiego alfabetu, ale również znaki interpunkcyjne, symbole arytmetyczne znaki, znaki specjalne, specjalne symbole, a nawet kosmiczne.

Binarne kodowanie informacji tekstowych

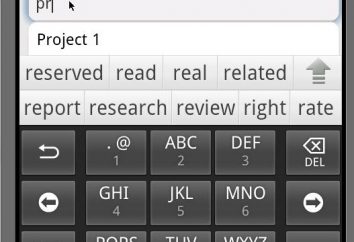

Poprzez naciśnięcie jakiegoś klawisza kontrolera wewnętrznego wysyła sygnał elektryczny, który jest przekształcany w kodzie binarnym. Kod jest dopasowany z pewnym symbolem, który jest wyświetlany na ekranie. Składania do alfabetu łacińskiego w cyfrowym formacie ASCII kodowania międzynarodowy system został stworzony. To wymaga 1 bajtu do zapisu jeden symbol sposób składa się z sekwencji ośmiu symboli zer i jedynek. Interwał nagrywania – od 00000000 do 11111111, czyli kodowanie informacji tekstowych przy użyciu tego systemu pozwala nam reprezentować 256 znaków. W większości przypadków to wystarczy.

ASCII jest podzielony na dwie części. Pierwszych 127 znaków (od 00000000 do 01111111) mają charakter międzynarodowy i są specyficzne symbole i litery alfabetu angielskiego. Druga część – przedłużenie (od 10000000 do 11111111) – przeznaczony do reprezentowania alfabetu narodowego, którego pisanie jest inny od łacińskiego.

Kodowanie informacji tekstowych ASCII jest zbudowany na zasadzie rosnącej kolejności, czyli większa liczba sekwencji liter, tym większa jest jego wartość kodu ASCII. Figury i rosyjskiej części tabeli są zbudowane na tej samej zasadzie.

Jednak w świecie istnieje kilka typów kodowania dla cyrylicą. Najczęstszym – jest KOI-8 (osiem-bitowe kodowanie, które zostały wykorzystane w latach 70. w pierwszym ruifitsirovannyh systemu operacyjnego Unix), ISO 8859-5 (opracowany przez Biuro Międzynarodowe Normalizacyjny), CP 1251 (kodowanie informacji tekstowych stosowane w  nowoczesny system operacyjny Windows), a także kodowanie 2-bajtowy Unicode, które mogą być wykorzystane do wprowadzenia 65,536 znaków. Taka różnorodność kodowania z uwagi na fakt, że zostały one opracowane w różnym czasie, w różnych systemach operacyjnych i różnych względów. Z tego powodu często mają trudności podczas przesyłania tekstu z jednego medium do drugiego – z niedopasowania kodującego użytkownik zobaczy zbiór ikon mylące. Jak mogę rozwiązać tę sytuację? W programie Word, na przykład, gdy dokument jest otwarty, pojawi się komunikat o problemach z wyświetlaczem tekstowym i oferuje kilka opcji transkodowania.

nowoczesny system operacyjny Windows), a także kodowanie 2-bajtowy Unicode, które mogą być wykorzystane do wprowadzenia 65,536 znaków. Taka różnorodność kodowania z uwagi na fakt, że zostały one opracowane w różnym czasie, w różnych systemach operacyjnych i różnych względów. Z tego powodu często mają trudności podczas przesyłania tekstu z jednego medium do drugiego – z niedopasowania kodującego użytkownik zobaczy zbiór ikon mylące. Jak mogę rozwiązać tę sytuację? W programie Word, na przykład, gdy dokument jest otwarty, pojawi się komunikat o problemach z wyświetlaczem tekstowym i oferuje kilka opcji transkodowania.

Zatem, kodowanie i przetwarzanie informacji tekstowych w trzewiach komputera – jest to proces trudny i czasochłonny zorganizowane. Wszystkie symbole dowolnego alfabetu są tylko pewien ciąg cyfr w systemie binarnym, jedna komórka – to jeden bajt informacji.